D

|

e acordo com Bock et al (2001), pode-se

dizer que após o simpósio de 1921 os teóricos se dividiram, em dois

grandes blocos, naquilo que se refere à compreensão da inteligência humana: os

da Abordagem Psicométrica da Psicologia Diferencial, e os da Abordagem

Psicométrica da Psicologia Dinâmica.

A medição contemporânea da inteligência pode

remontar a uma de duas tradições muito diferentes. Uma tradição concentrada em um

nível inferior, as capacidades psicofísicas, tais como acuidade sensorial,

força física e coordenação motora; a outra focalizada em um nível superior,

capacidade de julgamento, que nós, tradicionalmente, descrevemos como

relacionadas ao pensamento (STERNBERG, 2000, p. 401-402, grifo nosso).

Em sentido etimológico,

conforme dito por Pasquali (1996 apud GUTTMAN, 1971), psicometria seria toda a

classe de medida em Psicologia. Em seu sentido mais restrito, como é

normalmente entendida, psicometria constitui uma das várias formas de medição

em Psicologia.

A medida em ciências do comportamento, notadamente

na Psicologia, deveria ser chamada puramente de psicometria, similarmente ao

que ocorre em ciências afins a ela, onde se falam de sociometria, econometria,

politicometria, etc. Psicometria, contudo, tem sido abusivamente utilizada

dentro de um contexto muito restrito, referindo-se a testes psicológicos e escalas

psicométricas. De qualquer forma, a psicometria ou medida em Psicologia se insere

dentro da teoria da medida em geral que, por sua vez, desenvolve uma discussão

epistemológica em torno da utilização do símbolo matemático (o número) no

estudo científico dos fenômenos naturais. Trata-se, portanto, de uma

sobreposição, ou melhor, de uma interface entre sistemas teóricos de saber

diferentes, tendo a teoria da medida (PASQUALI, 1996 p. 21, grifo nosso).

Na verdade, Ciência empírica e Matemática

são sistemas teóricos ou de conhecimento totalmente diferentes, têm objetos e

metodologias próprios, distintos e irreversíveis entre si.

A Ciência tem como objeto os fenômenos da

realidade, ao passo que a Matemática estuda como seu objeto o símbolo numérico,

que é um conceito e não uma realidade empírica e nem uma propriedade desta

realidade (PASQUALI, 1996 apud FREGE, 1884).

A metodologia da Ciência é a observação sistemática

e a da Matemática é a dedução; o critério de verdade para a Ciência é o teste

empírico, ao passo que para a Matemática é a consistência interna do argumento.

Abordagem da Psicologia Diferencial da Inteligência

A Psicologia

Diferencial, baseada no positivismo, acredita que a tarefa da ciência é

estudar aquilo que é possível de se medir, ou seja, aquilo que é positivo. Assim,

a inteligência, para ser estudada, tem

que ser observada, mesmo não podendo ser observada diretamente, mas pode ser

medida através dos comportamentos humanos, que são expressões da capacidade

cognitiva. Dessa forma, se vê e se

mede a inteligência humana através de sua capacidade de verbalizar ideias,

compreender instruções, perceber a organização espacial de um desenho, resolver

problemas, adaptar-se a situações novas, comportar-se criativamente frente a

uma situação. A inteligência, nesta abordagem, seria um composto de habilidades

e poderia ser medida por meio dos conhecidos testes psicológicos de

inteligência (BOCK et al, 2001).

As primeiras conceptualizações de inteligência

datam do final do século XIX e devem-se, em grande parte, ao vasto contributo

de Sir Francis Galton no movimento da testagem. Este biólogo inglês, que nutria

um especial interesse pela hereditariedade humana (ou não fosse ele,

curiosamente, primo de Charles Darwin), foi responsável pelo primeiro vasto

corpo de dados sistemáticos sobre as diferenças individuais em processos

psicológicos simples, nomeadamente no que respeita à sensibilidade a estímulos

visuais, auditivos e cinestésicos, ao tempo de reação e a outras funções

sensório-motoras simples. Ele tinha a convicção de que os testes de discriminação

sensorial podiam servir como instrumento de avaliação da capacidade intelectual

do sujeito (LEMOS, 2007, p.10).

Francis Galton (1822-1911) foi um dos que

acreditava que a inteligência era uma função das capacidades psicofísicas e,

por muitos anos, manteve um laboratório bem-equipado, onde se media os

visitantes em uma ampla variação de habilidades psicofísicas e de

sensibilidades, tais como: discriminação

de peso; capacidade para ouvir pequenas diferenças entre as notas musicais, e

vários testes de força física. Clark Wissler, um dos seus seguidores,

tentou detectar relações entre os testes variados, as quais unificariam as

várias dimensões da inteligência logo enfraqueceu, quase caindo no

esquecimento, embora reaparecessem muitos anos mais tarde (STERNBERG, 2000 apud

GALTON, 1883).

A única informação que nos atinge, vinda dos acontecimentos

externos, passa, aparentemente, pelo caminho de nossos sentidos; quanto maior o

discernimento que os sentidos tenham da diferença, maior o campo em que podem

agir nosso julgamento e nossa inteligência. [

] Galton também notou que os idiotas tendem a ser deficientes na

habilidade para discriminar calor, frio, e dor, e essa observação, reforçou

ainda mais sua convicção de que a capacidade de discriminação sensorial deve

ser, geralmente, mais elevada entre os intelectualmente mais capazes (ANASTASI, 1972, p. 9).

Os métodos da escala de avaliação e do

questionário foram introduzidos por Galton, assim como o uso da técnica de

associação livre, depois utilizada para outros objetivos. Ele também foi

responsável pelo desenvolvimento de métodos estatísticos para a análise de

dados sobre diferenças individuais. E ainda selecionou e adaptou técnicas,

anteriormente deduzidas pelos matemáticos, colocando-as de forma que pudessem

permitir o seu uso por investigadores sem treinamento matemático, e que desejassem

tratar, quantitativamente, os resultados.

O famoso psicólogo Edwin Boring assim

definiu a inteligência: seja o que for, o que os testes medem.

Esta definição não é compartilhada pela maioria dos psicólogos cognitivos,

muito embora a tradição de se tentar compreender a inteligência através da

medição por testes tem uma longa história (STERNBERG, 2000, BORING, 1923).

Porquanto, uma alternativa à abordagem da

Psicologia Diferencial ou Psicofísica foi desenvolvida por Alfred Binet

(1857-1911). Ele e seu colaborador, Theodosius Simon, também tentaram avaliar a

inteligência, mas seu objetivo era muito mais prático do que puramente

científico.

Binet fora solicitado a planejar um procedimento

para distinguir os alunos normais dos mentalmente retardados (Binet &

Simon, 1916). Assim, planejaram medir a inteligência como uma função da

capacidade de aprender, dentro de um ambiente acadêmico. Na concepção de Binet,

o julgamento era a explicação para a inteligência, não a acuidade, a força ou a

habilidade psicofísica (STERNBERG, 2000, p.401 apud BINET & SIMON, 1916).

Para Binet, o pensamento inteligente ou

julgamento mental, compreende três elementos distintos: direção, adaptação e crítica. (i) a direção envolve saber o que tem de ser feito e como fazê-lo; (ii) a adaptação refere-se a habituar uma

estratégia para realizar uma tarefa e, depois, monitorizar essa estratégia

durante sua implementação; (iii) e a crítica é sua capacidade para criticar seus próprios pensamentos e ações (STERNBERG,

2000, BINET & SIMON, 1916).

Direção e adaptação, na concepção de Binet,

estão muito próximas das concepções atuais de inteligência, assim como a sua

noção previdente de crítica, considera a valorização atual dos processos

metagognitivos como um aspecto-chave da inteligência.

[...] Digamos

que nada é tão enganoso como a aparência física da inteligência; que é

necessário reagir contra suas impressões instintivas, e que seria inútil de

atribuir uma criança, que pode ser boa e inteligente, a responsabilidade um

físico ingrato [ ] quando for preciso

julgar um aluno específico, que se comece por um exame psicológico de sua

inteligência, e de seu caráter, e se os resultados deste exame são claramente

desfavoráveis ao sujeito examinado; neste caso somente, quer dizer, neste papel

totalmente de segundo plano, que a consideração dos sinais físicos da

inteligência poderia intervir, para ajuntar uma pequena confirmação e uma

explicação a um julgamento que nós teríamos feito, por outras razões e segundo

outros documentos; pois, a inteligência de uma criança se demonstra e se prova unicamente

por suas manifestações intelectuais (ZAZZO, 2010, p.116-117 apud BINET,

1909, p. 30, grifo nosso).

Ainda de acordo com Zazzo

(2010), no capítulo final de seu último livro, publicado, em 1911, sob o título:

Ideias modernas sobre as crianças, Binet faz críticas veladas aos

promotores da Psicologia Diferenciada e aos seus testes: A antiga pedagogia é como uma carruagem fora de moda: range, mas ainda

pode ser útil. A nova pedagogia tem o aspecto de uma máquina de precisão; mas

as peças parecem não ter relação umas com as outras, e a máquina tem um

defeito: ela não funciona. [...] nos ensinaram sobre as coisas da educação.

[...] eu procurei meu caminho entre a antiga pedagogia e aquela que nos

prometem os inovadores, gente do laboratório. [...] então guardemos sua

orientação, seu gosto pelos problemas reais. [...] Quanto aos inovadores, seu

mérito está em ter feito valer, na pedagogia como na pedologia, a

experimentação, a exigência de controle e de precisão. Mas seus testes

aplicados às cegas e suas experiências muito fragmentárias são, na maior parte

das vezes, inúteis: Essa gente não tem noção da escola e da vida [...] eles

parecem nunca colocar a cara para fora de seu laboratório [...] a antiga

pedagogia deve nos apresentar os problemas a serem estudados; a nova pedagogia,

os procedimentos de estudo.

Eu

creio que o conhecimento das aptidões das crianças é o mais belo problema da

pedagogia. Ele ainda não foi tratado em nenhum lugar, pelo menos do meu conhecimento,

e nós não possuímos atualmente nenhum procedimento seguro para procurar as

aptidões de um sujeito qualquer, criança ou adulto. [ ] métodos e exames que esclareceriam as

vocações, as aptidões e também as inaptidões seriam incomensuravelmente úteis a

todos. Assim que a parte teórica do problema for resolvida, as aplicações práticas

não tardarão, e toda uma organização intelectual de posicionamentos ocorreria,

eu sei disto. Eis as grandes perspectivas para a Psicologia e a Pedagogia

experimentais [...] (ZAZZO, 2010, p. 128-129 apud BINET, 1910. p. 5-11).

Lewis Terman, da Universidade de Stanford,

baseou-se no trabalho de Binet e Simon, e construiu a versão mais antiga do que

veio a ser denominado de Escalas de Inteligência Stanford-Binet. Durante anos, ele

foi o padrão para os testes de inteligência Wechsler.

Wechsler, como Binet, tinha uma concepção de

inteligência que ultrapassava aquilo que seu próprio teste media. Embora

Wechsler acreditasse, evidentemente, no valor de tentar-se medir a inteligência,

não limitava sua concepção de inteligência aos escores de testes. Ele

acreditava que a mesma é fundamental em nossa vida cotidiana. Ela não é

simplesmente um escore de teste ou alguma coisa que usamos na escola. Usamos

nossa inteligência não apenas para realizarmos testes e fazermos temas de casa,

mas também para nos relacionarmos com as pessoas, desempenharmo-nos com

eficiência em nossos empregos e administrarmos nossas vidas em geral

(STERNBERG, p. 404, grifo nosso).

Medir a inteligência é apenas uma das

diversas abordagens para estudá-la, e duas pelo menos se destacam: (1)

estruturalismo versus funcionalismo e

(2) natureza versus educação. Os

psicólogos cognitivos sempre se perguntam: (a) deve-se concentrar os estudos na estrutura ou nos processos? (b) O

que fundamenta a inteligência: a herança

genética de um indivíduo, os atributos por ele adquiridos ou alguma espécie de

interação entre ambos?

Destarte, os psicólogos interessados na estrutura da inteligência têm confiado

na análise fatorial como o

instrumento indispensável para suas pesquisas.

A análise fatorial é um método estatístico para

separar um construto (inteligência), neste caso, em muitos fatores ou

habilidades hipotéticas que os pesquisadores acreditam formar a base das

diferenças individuais no desempenho nos testes. Os fatores específicos

derivados, naturalmente, ainda dependeriam das perguntas específicas formuladas

e das tarefas avaliadas (STERBERNG, 2000, p.404).

A análise fatorial baseia-se em estudos de

correlação. Na pesquisa sobre inteligência, uma análise deste tipo pode

envolver as seguintes etapas: (i) dar a um grande número de pessoas vários

testes diferentes de capacidades; (ii) determinar as correlações entre todos

esses testes; (iii) e analisar estatisticamente essas correlações para

simplificá-las em um número relativamente pequeno de fatores, que resumem o

desempenho das pessoas nos testes.

Embora os investigadores tenham concordado

com esses procedimentos, os resultados obtidos foram divergentes entre os seus

diversos teóricos. As teorias fatoriais mais expressivas foram as de Spearman,

de Thurstone, de Guilford, de Cattell, de Vernon e de Carrol.

Análise Fatorial ou Teoria dos Dois fatores

Charles Spearman (1863-1945), utilizando

estudos analítico-fatoriais foi reconhecido pelo seu mérito como o idealizador

da análise fatorial ou teoria dos dois fatores.

A primeira teoria de organização do traço,

baseada em analise estatística de resultados de teste, foi desenvolvida por

Spearman. Na formulação original, ela sustentava que todas as atividades

intelectuais participam de um único fator comum, chamado de fator geral ou “g”. Além disso, a teoria supunha

numerosos fatores específicos denominados de “e”, cada um dos quais, estritamente, específico de uma única

atividade. A correlação específica entre duas funções quaisquer era, dessa

forma, atribuída ao fator “g”. Desta

forma, quanto maior a saturação de duas funções “g”, tanto maior a correlação entre elas. Por outro lado, a presença

dos fatores específicos tendia a diminuir a correlação entre funções (ANASTASI,

1972).

Spearman concluiu que a inteligência pode ser

compreendida tanto em função de um único fator geral que permeia o desempenho

em todos os testes de capacidade mental, como em função de um conjunto de

fatores específicos, cada um dos quais estando envolvido no desempenho em

apenas um único tipo de teste de capacidade mental. Os fatores específicos são

de interesse casual apenas, devido à sua estrita aplicabilidade. O

fator geral, que ele denominou de “g”, fornece a chave para compreender-se a

inteligência (STERNBERG, 2000, p.404, grifo nosso).

De

acordo com Anatasi (1972, p.395), “o principal objetivo da análise fatorial é

simplificar a descrição dos dados, através da redução do número de dimensões ou

variáveis necessárias”. O fator geral “g”

dependeria de uma energia mental essencialmente biológica e inata, enquanto os fatores específicos dependeriam da

aprendizagem, ou seja, seriam treináveis e educáveis, e ativados pelo fator g

(ALMEIDA, 2002 apud ALMEIDA, 1988; RIBEIRO, 1998).

Na formulação de sua teoria, Spearman

aceitou a possibilidade de pequenos fatores de grupo, muito limitados e

desprezíveis. Depois de investigações posteriores, por parte de seus

discípulos, ele incluiu fatores de grupo muito mais amplos, tais como: a capacidade aritmética, mecânica e de

linguagem.

Desde o início, Spearman compreendeu que a Teoria

dos Dois Fatores precisava ser limitada. Quando as atividades comparadas são

muito semelhantes, pode ocorrer certo grau de correlação, além da que pode ser

atribuída ao fator “g”. Assim, além dos fatores gerais e específicos, pode

haver outra classe de fatores intermediários, nem tão rigorosamente específicos

quanto os fatores e, nem tão universais quanto o “g”. Esse fator, comum a um

grupo de atividades, mas não a todas, tem sido denominado fator de grupo (ANASTASI,

1972, p. 401, grifo nosso).

Capacidades Mentais Primárias

Louis Thurstone (1887-1955), segundo Sternberg

(2000), concluiu que o cerne da

inteligência reside não num único fator, mas em sete desses fatores, que

ele identificou como capacidades mentais primárias. Já para Anastasi (1972),

Thurstone propôs, aproximadamente, doze

fatores grupais, confirmando os sete como os mais frequentemente aceitos, conforme descritos no quadro abaixo.

FATOR DE MEDIDA

|

CAPACIDADE MENTAL

|

FORMAS DE MEDIÇÃO

|

Compreensão Verbal

|

É o principal fator em testes como os de compreensão de leitura,

analogias verbais, sentenças desorganizadas, raciocínio verbal e comparação

verbal, e comparação de provérbios.

|

Medida por meio de testes de vocabulário

|

Fluência Verbal

|

Encontrado em testes de anagramas, rimas ou apresentação de nomes de

certa categoria (por exemplo, nomes de meninos ou de palavras que comecem com

a mesma letra.

|

Medida por testes de tempo limitado que exigem que o tomador do teste

pense em tantas palavras quantas possíveis que comecem com uma dada letra

|

Raciocínio Indutivo

|

Originalmente, Thurstone propôs um fator indutivo e um dedutivo. A

melhor medida do último era feita através de testes de raciocínio

silogístico, e o primeiro por testes que exigiam que o sujeito descobrisse

uma regra, tal como ocorre num teste de completação de série de números. No

entanto, a prova de um fator indutivo. Além disso, outros investigadores

sugerem um teste de raciocínio geral, cuja melhor medida é feita por testes

de raciocínio aritmético.

|

Medido por testes como tarefas de completar analogias e séries

numéricas

|

Visualização Espacial

|

Talvez este fator represente geométricas ou espaciais fixas, e o

outro, visualização de mudanças, na qual transformações ou posições

transformadas precisam ser visualizadas. Existem também provas de um terceiro

fator de imagens cinestéticas.

|

Medida por testes que exigem rotação mental de figuras de objetos

|

Número

|

Identifica-se mais diretamente com rapidez e precisão de cálculo

aritmético.

|

Medido por testes de cálculos e por resolução de problemas matemáticos

simples

|

Memória Associativa

|

É encontrado, principalmente, em testes que exigem memorização

automatizada de pares associados. Existem algumas provas segundo as quais

esse fator pode refletir até que ponto os recursos mnemônicos são utilizados.

|

Medida por testes de evocação de palavras e de imagens

|

Rapidez Perceptiva

|

Apreensão rápida e precisa de minúcias, semelhanças e diferenças

visuais. Este fator pode ser o mesmo já identificado como fator de rapidez,

por investigadores anteriores.

|

Medida por testes que exigem que o tomador do teste reconheça pequenas

diferenças em figuras ou risque os as em fileiras de letras variadas

|

Quadro: Fatores

de Medida da Inteligência de Thurstone

Fonte: Adaptado de Sternberg (2000, p. 404) e de

Anastasi (1972, p. 402-403)

Modelos Multidimensionais de Inteligência

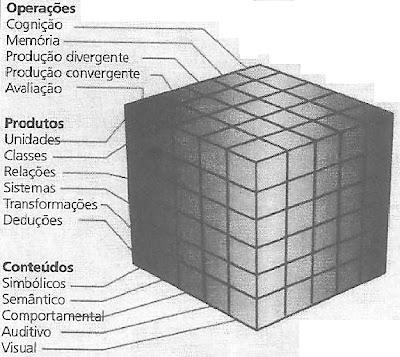

J.P. Guilford (1967-1982) desenvolveu o

modelo de estrutura do intelecto, incluindo até 150 fatores da mente,

completamente oposto ao Modelo do Fator Único “g”, de Spearman.

Para Guilford, segundo Sternberg (2000): a

inteligência pode ser compreendida em função de um cubo, conforme a figura abaixo,

que representa a interseção de três dimensões: várias operações, conteúdos e

produtos, onde (i) as operações são

simplesmente processos mentais, como a memória e a avaliação, ou seja: fazer julgamento, tais como determinar se

uma dada declaração é fato ou opinião, baseia-se no pensamento racional ou na

emoção ou no prejuízo; (ii) os conteúdos

são os tipos de termos que aparecem em um problema, tais como os semânticos, como palavras, e os visuais,

como figuras; (iii) os produtos

são os tipos de respostas exigidas, tais como unidades, ou seja: palavras, números ou figuras simples,

classes/hierarquias e deduções.

Entretanto, para muitos psicólogos, a

contribuição mais valiosa de Guilford foi sugerir os vários tipos de operações

mentais, de conteúdos e de produtos em suas concepções e em suas avaliações da

inteligência.

Figura: Estrutura da Inteligência de Guilford

Fonte:

Extraído da Figura 14.2 de Sternberg (2000, p. 406)

Modelos Hierárquicos da Inteligência

O primeiro modelo hierárquico de

inteligência foi desenvolvido por Philip E. Vernon, em 1950, onde observou uma

divisão geral entre capacidades mecânico-práticas

e educativo-verbais.

Vernon

propõe uma teoria em que, no topo da hierarquia, emerge o fator g de Spearman;

no nível seguinte surgem dois fatores de grande grupo: verbal-educativo e

perceptivo-mecânico; em seguida estes fatores subdividem-se em fatores de

pequeno grupo ou secundários, bastante próximos dos fatores de Thurstone; e,

finalmente, um conjunto bastante instável de fatores ainda mais específicos. Numa

formulação posterior do seu modelo, ele fez correlações entre fatores,

especialmente os relacionados com a educação. As habilidades científicas e

técnicas, por exemplo, estariam relacionadas com habilidades espaciais,

mecânicas e numéricas. (ALMEIDA, 2002 apud ALMEIDA, 1988; ANASTASI,

1990; RIBEIRO, 1998; STERNBERG & PRIETO, 1997; ANASTASI, 1990).

O segundo modelo hierárquico de

inteligência foi elaborado por Raymond Cattell, em 1971, estabelecendo que a

inteligência geral abrange dois subfatores principais: a capacidade fluida, que envolve a rapidez e a exatidão do raciocínio

abstrato, especialmente para novos problemas; e capacidade cristalizada, que envolve conhecimento e vocabulário

acumulados. Agrupados nesses dois principais subfatores estão outros, mais

específicos.

Cattell propõe uma segunda teoria

hierárquica da inteligência, conhecida pela teoria da inteligência fluida (gf)

e cristalizada (gc). Para Cattell, o fator g pode subdividir-se numa

inteligência fluida (mais confinada ao próprio fator geral de Spearman) e numa

inteligência cristalizada (capacidades assentes no uso das habilidades).

Bastante na linha de Thurstone e de Guilford, Cattell defende a existência de

dezenove fatores primários ou de primeira ordem, conforme o quadro abaixo (ALMEIDA,

2002).

Quadro: Fatores

Primários Identificados por Cattel

Fonte: Almeida (2002)

Ainda segundo

Almeida (2002), a partir de correlações estes fatores primários, Horn &

Cattell apresentaram vários fatores secundários ou de segunda ordem, conforme

se pode vê no quadro abaixo.

FATOR

|

CARACTERIZAÇÃO DO FATOR

|

Compreensão verbal (V)

|

Compreensão de palavras e ideias.

|

Aptidão numérica (N)

|

Facilidade na manipulação de números.

|

Fator Espacial (S)

|

Compreensão de transformações de

figuras num espaço bi ou tridimensional.

|

Velocidade perceptiva (P)

|

Avaliação rápida e eficiente de

semelhanças ou diferenças em figuras.

|

Velocidade de encerramento (Cs)

|

Capacidade para reconstruir uma imagem

ou gestalt quando partes do estímulo estão omissas.

|

Raciocínio indutivo (I)

|

Raciocínio do específico para o geral.

|

Memória associativa (Ma)

|

Aptidão para evocar unidades de

informação fornecidas em pares.

|

Aptidão mecânica (Mk)

|

Resolução de situações que envolvam os

princípios da física, da mecânica ou outros conhecimentos práticos.

|

Flexibilidade de encerramento (Cf)

|

Aptidão para reconhecer determinado

padrão de estímulos num determinado campo perceptivo mais global.

|

Amplitude de memória (Ms)

|

Evocação de informação solta,

recentemente apresentada.

|

Ortografia (Sp)

|

Aptidão para reconhecer palavras com

erros ortográficos.

|

Avaliação estética (E)

|

Aptidão para detectar qualidades

artísticas.

|

Memória significativa (Mm)

|

Memorização de pares de elementos

entre os quais existe uma ligação com significado.

|

Originalidade I (O1)

|

Fator que avalia a flexibilidade

espontânea dos indivíduos.

|

Fluência ideacional (Fi)

|

Capacidade de produzir ideias sobre um

determinado tópico.

|

Fluência de palavras (W)

|

Fator que respeita a produção rápida

de palavras.

|

Originalidade II (O2)

|

Aptidão para combinar dois objetos

afins para produzir um novo objeto.

|

Precisão (A)

|

Capacidade de movimentos rápidos e

precisos envolvendo a coordenação sensório-motora.

|

Representação gráfica (Rd)

|

Capacidade de representação de

estímulos através do desenho.

|

Quadro: Fatores

Secundários de Horn & Cattell

Fonte: Almeida

(2002)

Brody

e Brody, em 1976, defendem que a divisão entre inteligência fluida e

cristalizada não se pode confundir com a suposição de dois fatores primários

independentes. Ambas se relacionam de forma moderada e positiva, o que não

impede origem e natureza distintas: gf

traduz uma aptidão essencialmente biológica, gc uma capacidade decorrente da

aculturação dos indivíduos. Com efeito, o

desenvolvimento e a aquisição das aptidões depende não só dos processos de

aculturação (experiências educativas), mas também do grau de gf de cada sujeito. A inteligência

fluida funcionaria, assim, como o potencial intelectual do indivíduo

(ALMEIDA, 2002).

Um terceiro

modelo hierárquico de inteligência foi desenvolvido por vários autores que

recorreram à análise fatorial, conforme está disposto na figura abaixo.

No nível inferior, aparecem as

aptidões intelectuais defendidas por Thurstone. No nível intermédio, surgem

fatores ditos gerais e já mais próximos da teoria de Horn-Cattell: Inteligência

fluida (Gf) que abarca fatores primários tais como Indução (I), Raciocínio

geral (R) e Cognição das relações figurativas (CFR); Inteligência cristalizada

(Gc) que abarca fatores primários como a Compreensão verbal (V) e a Cognição de

relações semânticas (CMR); o fator geral de Visualização (Gv) que abarca a

Visualização (Vz), Orientação espacial (S) e Flexibilidade de encerramento

(Cf); o fator de geral velocidade (Gs) e precisão do processamento de

informação em tarefas cognitivas de não alta complexidade cognitiva, e que

abarca fatores primários como a aptidão Numérica (N) e a aptidão

Perceptiva (P); e o fator geral de

Evocação (Gr) da informação estruturada em conhecimento, ou seja, na memória em

longo prazo, e que abarca fatores primários como a Fluência de ideias (Fi) e a

Fluência de palavras (Fw). No nível superior, encontramos um fator de

inteligência geral (g), no qual todas as aptidões de segunda ordem apresentam

saturações elevadas (como a saturação de gf é próxima da unidade, este fator g

pode assumir-se como equivalente à inteligência fluida) (ALMEIDA, 2002, P. 12)

Figura: Modelo Hierárquico de Gustafsson

Fonte:

Almeida (2002, p.12)

Um quarto modelo hierárquico foi

desenvolvido por Horn e Noll, conforme se apresenta na Figura 04. E ainda segundo Almeida (2002), o modelo concebe

nove aptidões dispostas no quadro abaixo:

APTIDÕES

|

CAPACIDADES

|

|

Gf

|

Inteligência

fluida

|

Capacidade para apreender relações

entre estímulos e para fazer inferências e compreender implicações entre os

estímulos, particularmente em tarefas novas e complexas.

|

Gc

|

Inteligência

cristalizada

|

Capacidade para adquirir em extensão e

profundidade o conhecimento da cultura dominante.

|

Gq

|

Conhecimento

quantitativo

|

Capacidade para usar informação

quantitativa e para manipular símbolos numéricos.

|

Glr

|

Armazenamento

e recuperação da informação à longo prazo

|

Capacidade para armazenar informação

por um longo período de tempo e para recuperá-la fluentemente mais tarde

através de associações.

|

Gsm

|

Memória

a curto prazo

|

Capacidade para manter em consciência

a informação e evocá-la uns segundos depois.

|

Gs

|

Velocidade

de processamento

|

Capacidade para rapidamente captar e

responder a tarefas simples, em períodos de tempo curtos.

|

CDS

|

Velocidade

de decisão correta

|

Capacidade para rapidamente decidir e

responder com acuidade a tarefas de dificuldade moderada.

|

Ga

|

Processamento

auditivo

|

Capacidade para perceber padrões de

sons, para manter a consciência da ordem e do ritmo de sons sob condições de

distorção e distração, e para compreender relações entre diferentes grupos de

sons.

|

Gv

|

Processamento

visual

|

Capacidade para perceber e manipular

símbolos variando a forma e identificando variações na sua configuração

espacial

|

Quadro: Modelo

Hierárquico de Inteligência de Horn e Noll

Fonte: Adaptado de

Almeida (2002)

Como se pode observar, os fatores

do modelo hierárquico de inteligência de Horn & Noll, apresentam níveis em sequencia

de tratamento da informação, assumindo a forma figurativa e a verbal.

Figura: Modelo Hierárquico de Inteligência de

Horn

Fonte:

Almeida (2002, p.13)

O quinto modelo hierárquico da inteligência

pertence a Jack Carroll, e foi apresentado, mais recentemente, em 1993, como se

observa na figura abaixo. O modelo, construído através da análise de dados

coletados por longos sessenta nos, ou seja: entre os anos de 1927 e 1987, compreende

três estratos: (1) Estrato I, que inclui muitas estritas capacidades específicas,

por exemplo: capacidade de soletração,

rapidez de raciocínio; (2) Estrato II, que abrange várias capacidades

gerais, por exemplo: inteligência fluida

e inteligência cristalizada; (3) e o Estrato III, que é justamente uma

inteligência geral separada, muito semelhante ao fator g de Spearman.

Desses estratos, o mais interessante é o estrato

médio, que não é demasiadamente estrito, nem demasiadamente abrangente. Além da

inteligência fluída e da inteligência cristalizada. Carroll inclui no estrato

médio os processos de aprendizagem e de memória, a percepção visual, a

percepção auditiva, a produção fácil de ideias (similar à fluência verbal) e a

rapidez que inclui tanto a mera rapidez de resposta, quanto à rapidez da

resposta acurada). Apesar de Carroll não ter iniciado um novo empreendimento,

pois muitas das capacidades, em seu modelo, tinham sido mencionadas em outras

teorias, ele integra magistralmente uma grande e variada autoridade ao seu

modelo [ ] (STERNBERG, 2002, p. 407).

Figura: Modelo Hierárquico de Inteligência de

Carroll

Fonte: Hernández

(2004, p.15)

O estudo de Carroll encerra um período de

busca por componentes da inteligência e levou a um novo patamar as pesquisas da

abordagem psicométrica. Atualmente, a tendência é ampliar o enfoque dos estudos

da inteligência englobando variáveis cognitivas e não cognitivas num esquema ou

modelo de processamento de informação. Um desses novos modelos é o resultado da

união das teorias que melhor embasamento empírico apresenta a Teoria de

Inteligência Fluída e Cristalizada de Cattell e Horn e a Teoria dos Três

Estratos de Carroll, dando origem ao que se denominou de Teoria

Cattell-Horn-Carroll das Habilidades Cognitivas, ou Teoria CHC, com

acréscimos de processamento de informação, onde apresenta a nova distribuição

das habilidades específicas. Das setenta e cinco, as seis que estão em itálico

correspondem àquelas que Carroll considera relacionadas ao desempenho acadêmico

e não à inteligência; as dezessete habilidades em negrito, por sua vez,

correspondem àquelas que foram distribuídas em habilidades diferentes de sua

proposta original. (HERNÁNDEZ, 2004 apud FLANAGAN, MCGREW & ORTIZ, 2001).

Flanagan, McGrew e Ortiz (2000) consideram o modelo

Cattell-Horn-Carroll como a mais completa descrição de inteligência da

atualidade. É o resultado da análise de centenas de conjuntos de dados não

restritos a um só tipo de bateria de testes. Os autores relatam que isso

permitiu identificar de forma mais clara a relação entre a inteligência e o

desempenho acadêmico. Distribuindo-se os dez domínios de habilidades amplas num

continuum observa-se num extremo as habilidades mais cognitivas, relacionadas às

habilidades gerais resultantes de experiências mais informais e não relativas à

escolaridade. No extremo oposto localizam-se as habilidades especializadas,

resultantes de experiências educacionais formais (HERNÀNDEZ, 2004, p. 21).

Segundo Hernàndez (2004), Flanagan, McGrew

e Ortiz (2000) elaboraram o esquema visto na figura abaixo, onde se vê da

direita para a esquerda, as habilidades mais relacionadas à escolaridade

referem-se ao conhecimento matemático e à leitura e escrita. A inteligência

cristalizada remete a um processo intermediário entre cognição e aprendizagem,

pois envolve não apenas processos gerais de pensamento, como desenvolvimento da

linguagem, mas também processos mais relacionados à aprendizagem, como por

exemplo, sensibilidade gramatical. Ressalta-se que a inteligência cristalizada

não é sinônimo de desempenho acadêmico, pois não se refere apenas aos conteúdos

aprendidos, mas também aos processos cognitivos. As habilidades restantes:

processamento auditivo, inteligência fluída, processamento visual, recuperação

de memória de longo prazo, memória de curto prazo, velocidade de decisão e

velocidade de processamento, são consideradas as habilidades cognitivas que são

menos influenciadas pelas atividades acadêmicas embora exerçam influência na

aprendizagem, isto é, a escolaridade contribui apenas indiretamente para o

desenvolvimento dessas habilidades, embora o nível de desenvolvimento cognitivo

que o indivíduo atinge nessas habilidades favoreça o seu desempenho acadêmico.

Um exemplo disso refere-se à habilidade de

processamento auditivo, especificamente a habilidade de compreender o estímulo

auditivo em condições inadequadas. No cotidiano de sala de aula, mesmo que o

professor fale pausada e adequadamente, essa estimulação sonora não é

suficiente para garantir o desenvolvimento da capacidade da criança em discriminar

o estímulo auditivo. Mas, o contrário é verdadeiro, a criança que tiver um

desenvolvimento aquém do esperado nessa habilidade pode apresentar dificuldades

de aprendizagem por não compreender o que o professor está falando.

Figura: Esquema da distribuição

das habilidades no continuum.

Fonte: Hernández (2004, p.21)

Modelo da Representação Radial de Complexidade – RADEX

Ainda de acordo com Hernàndez (2004), outro

modelo é a proposta de Mashalek, Lohman e Snow, representado na figura abaixo,

resultado de uma análise do modelo Radex de Guttman à luz dos novos modelos

psicométricos.

Para Sternberg (1990), Louis Guttman (1916-1987), em

1954, apresentou uma proposta diferente dos modelos hierárquicos, onde se

aplicou a técnica de análise multidimensional, permitindo a integração das

teorias fatoriais ou psicométricas com o processamento humano de informação. Neste

caso, enquanto as teorias psicométricas realizam uma análise mais generalista

das capacidades humanas, o processamento humano de informação proporciona

análises mais detalhadas destas mesmas capacidades.

Figura: Modelo da

Representação Radial de Complexidade - RADEX

Fonte: Hernández (2004, p.25)

Guttman compreendia as habilidades da

inteligência como facetas que se relacionam entre si, distribuindo seus

resultados num espaço euclidiano e não numa árvore ou estrutura. A técnica foi

apresentada em 1968, e seu objetivo era encontrar o menor espaço entre

coordenadas em uma configuração de pontos. O modelo é integrado por duas

partes, que são denominadas de simplex e circumplex. O simplex refere-se à

distância que um determinado ponto, no caso uma medida de habilidade, tem do

centro, e o circumplex refere-se ao arranjo que essas medidas adotam ao redor

do centro, distribuindo-se de acordo com as correlações entre elas (HERNÀNDEZ

(2004)

Diversos autores (Snow, Kyllonen e

Marshalek, 1984; Sternberg, 1990; Carroll, 1993) relataram a importância das ideias

de Guttman a respeito do Radial Expansion of Complexity, apresentadas em

1954, mesmo que as mesmas não tenham tido grande impacto na época. Esse modelo

abarca informações que a análise fatorial não explora. Carroll (1993) relata

que para Guttman a inteligência deveria ser descrita em termos de

"sentenças mapeadoras" através das quais se podem descrever as

relações entre cada uma de suas facetas. Para ele, a realização de um indivíduo

numa tarefa com determinado nível de dificuldade significa que ele

provavelmente obterá sucesso em outras tarefas do mesmo nível e falhará

naquelas com nível maior.

Sua proposta de Representação Radial de

Complexidade (Radial representation of complexity) ou RADEX distribuía

os resultados nos diversos testes realizados pelos indivíduos no espaço

euclidiano no qual quanto menor a distância entre dois pontos, maior a

correlação entre eles. Após a distribuição dos resultados no espaço, pode-se subdividi-lo

em facetas, como fatias de uma torta, organizando-os de acordo com as

correlações e as variáveis psicológicas envolvidas na realização dos mesmos

testes.

E um último modelo é a proposta de Acherman

sobre a inteligência de adultos a Teoria da Inteligência-como-processo, Personalidade,

Interesses, Inteligência-como-conhecimento - PPIK, que também amplia a

proposta de Cattell e Horn de inteligência fluída e cristalizada acrescentando-se

ainda, aspectos de personalidade e interesse.

Abordagem Dinâmica

da Inteligência

Por outro lado, a abordagem da Psicologia Dinâmica interpreta, de forma

diferente, os dados obtidos por meio dos testes psicológicos.

Os dados obtidos nos testes deixaram de ser

considerados como medidas da inteligência. Passaram a ser vistos como medidas

apenas de eficiência do sujeito e as alterações dessa eficiência encaradas como

sintomas de perturbações globais e não como indicadores de potencial

intelectual deficiente. [ ] Assim,

nesta abordagem, o termo inteligência é questionado, porque supõe uma

existência distinta do organismo na sua totalidade. A inteligência existiria

como algo, ou algum fator no indivíduo, que poderia ser medido e avaliado. [ ] Nesta abordagem dinâmica, a inteligência

passa a ser um adjetivo - inteligente - que qualifica a produção cognitiva e

intelectual do homem. Por isso, nesta abordagem, os dados obtidos nos testes

não são medidas da inteligência, mas medidas da eficiência intelectual do

indivíduo (BOCK et al, 2001, p.183 apud ANCONA-LOPEZ, 1987, p.52, grifo

nosso).

Para esta abordagem, os níveis baixos

apresentados nos testes, não significa que o indivíduo tem pouca inteligência,

até porque o indivíduo deve ser visto na sua globalidade.

De acordo com Bock et al (2001), o

indivíduo quando apresenta dificuldades

de verbalizar, de resolver problemas, ou de aprender o que lhe é ensinado deve

ser compreendido, não como tendo deficiência intelectual ou sendo pouco

inteligente, mas por, provavelmente, estar vivendo num momento de dificuldades

psicológicas, ou mesmo conflitos relacionados ao seu desenvolvimento,

provocando sintomas de pouca produção intelectual, e que deve ser recuperado em

todas as suas capacidades globais.

Porquanto, nesta

abordagem, os testes de inteligência passam a ser instrumentos auxiliares na

identificação das dificuldades, que são encaradas como sintomas de conflitos, e

ainda ajudam na sua recuperação, ao invés de fazer apenas um trabalho de

classificação, e às vezes até, os testos podem ser dispensáveis.

O estudo do comportamento intelectual ou cognitivo

do indivíduo, ou outro qualquer, é feito em função de sua personalidade e de

seu contexto social. O indivíduo faz parte de um meio, no qual age, manipula,

transforma, desenvolvendo concomitantemente suas estruturas psíquicas. A

inteligência deixa de ser estudada como uma capacidade isolada, para ser

pensada como capacidade cognitiva e intelectual que integra a globalidade

humana. Assim, quando é enfocada uma produção intelectual do homem, esta é

analisada nos seus componentes cognitivos, afetivos e sociais (BOCK, 2001, p. 184, grifo nosso).

A noção de unidade

do organismo e totalidade de reações enfatizou a impossibilidade de se decompor

a personalidade em funções isoladas, visto dessa forma, a inteligência, nesta

abordagem, não tem lugar de destaque, e é compreendida como capacidade

cognitiva ou intelectual, não podendo ser estudada, analisada, nem

compreendida, isolada da totalidade de aspectos, aptidões, capacidades do ser

humano. Assim, todas as expressões do homem são carregadas de elementos

psíquicos, decorrentes de sua capacidade cognitiva, afetiva, corporal. E os

atos, que são adjetivados como inteligentes, não estão isentos de componentes

afetivos, além dos cognitivos (BOCK, 2001).

A Psicologia

Dinâmica entende que o ser humano, quando está bem psiquicamente, consegue

tratar de forma adequada os seus conflitos, enfrentando os problemas e desafios

que lhe são apresentados, com criatividade, em melhores condições, grandes

atitudes e atos considerados inteligentes.

Binet e Henri, num artigo publicado em 1895, na

França, criticaram a maioria das séries disponíveis de testes, por serem

demasiadamente sensoriais e por se concentrarem, indevidamente, em habilidades

simples e especializadas. Além disso, sustentavam que, na mensuração de funções

mais complexas, não é necessária grande precisão, pois as diferenças

individuais são maiores em tais funções. Propunha-se uma extensa e variada lista de

testes, abrangendo funções como a memória, imaginação, atenção, compreensão,

sugestionabilidade, apreciação estética e muitas outras (ANASTASI,

1972, p.11 apud BINET: HENRI, 1895, p.411-463, grifo nosso).